缺乏仁爱如何损害人们对AI管理的信任

Li, M., & Bitterly, T. B. (2024). How perceived lack of benevolence harms trust of artificial intelligence management. Journal of Applied Psychology. https://doi.org/10.1037/apl0001200

摘要

随着组织越来越多地使用AI来补充和替代人类管理,了解影响员工对AI管理信任度的因素变得至关重要。通过一项对中国大陆400名骑手进行的预注册实地研究和三项预注册实验(N=2350),作者发现,AI管理被认为不如人类管理仁慈。鉴于仁慈是对领导者信任的重要前提,这种感知对AI管理的信任产生了负面影响,即使在控制感知能力和诚信的情况下也是如此。在高同理心需求的情境中,即个体寻求能够理解和体验他们所感受的情绪的管理时,员工更倾向于人类管理而非AI管理,这与低同理心需求情境形成了对比。这些发现加深了我们对信任的理解,并为AI管理的实施和采用提供了重要的理论和实践见解。

研究问题与理论模型

随着人工智能(AI)在组织管理中的角色日益增加,理解员工对AI管理的信任变得尤为关键,但现有研究关于算法管理信任的结论仍模棱两可。

- 【消极】Dietvorst等(2018)发现,当用户无法改变算法决策时,即使算法表现优于人类,他们也会表现出强烈的算法厌恶情绪,这表明个人不喜欢缺乏自主权和屈从于算法系统。同样,Tong等(2021)发现,与人类反馈系统相比,人工智能反馈系统提高了员工绩效,但一旦披露人工智能反馈系统的存在,这种效果就会逆转。

- 【积极】Raveendhran和Fast(2021)发现,隐私问题导致员工更喜欢由人工智能系统进行密切监控。

先前的研究结果强调,理解对AI管理的信任需要将员工视为人工智能的下属,这表明以前未曾研究过的机制可能会丰富我们对采用人工智能管理的理解,并表明情境因素在这种关系中发挥着重要作用。

(萜妹的注释:实话实说,我可以理解这里是要点出研究的重要性并给下文铺垫,但是读的时候感觉接不上“理解对AI管理的信任需要将员工视为人工智能的下属”这前半句的结论。)

在人与人的互动中,感知仁慈和情感情境是信任的基础。尽管学者已经开始考察对AI的感知仁慈,但他们要么是将AI代理的感知仁慈与其他AI代理进行比较,而非与人类进行比较;要么是考察自愿使用AI决策的人类用户的观点,而非作为AI决策的下属。然而,先前的研究表明,人们对于机器做出道德决策感到不安,因为AI代理缺乏人类思维和情感体验。如果这种情感体验的缺乏导致员工认为AI管理者不为人类好并缺乏仁慈,那么员工可能更不愿意接受AI取代组织中的人类管理者,尤其是在同理心至关重要的情况下,这可能会产生负面的下游后果,如降低员工生产率、减少组织承诺(如减少组织公民行为)和提高员工离职率。

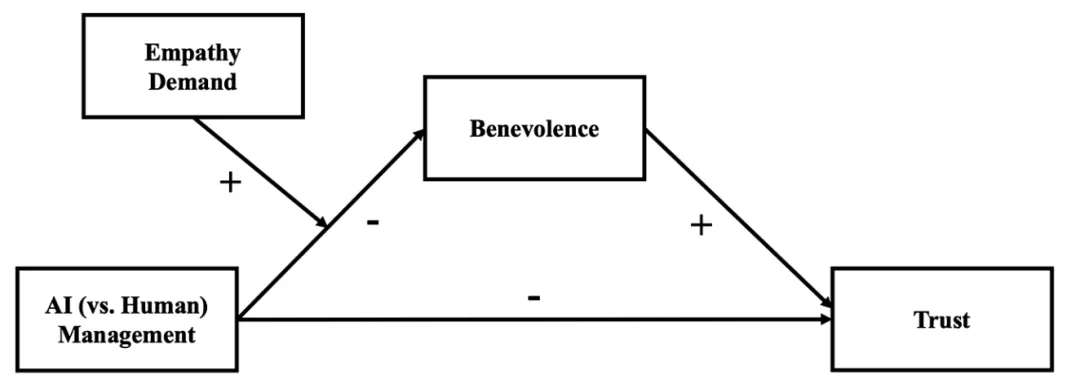

因此本文拟探讨AI管理是否被认为比人类管理缺乏仁慈,进而对信任产生的负面影响,以及这种潜在的负面关系是否在需要同理心的环境中加剧?

虽然AI代理在许多领域表现出高能力(如在国际象棋、围棋和扑克中击败人类),但它们被感知为在体验情感的能力上存在缺陷。AI可以使用卷积神经网络等技术来识别和模仿人类情感进行面部表情分析。然而,AI对情感的识别和表达是基于模式识别和数据分析,而不是通过“有感知生命体的经验”的真正情感理解。虽然AI可以模拟对情感的理解,但它缺乏以人类方式体验情感的能力,并且人类认识到了这一限制。鉴于体验情感的能力被视为人类对他人产生共鸣和从事仁慈行为所必需的,作者预期AI缺乏与他人共情的能力将损害它与人类管理者相比被视为仁慈的程度,从而阻碍人类下属与AI管理者之间的信任发展。

AI管理与人类管理、感知仁慈度和信任之间的关系可能会因情境是否需要同理心而有所不同。作者将同理心需求概念化为一个人希望对方体验到他们所感受到的情感的程度。鉴于同理心与帮助行为密切相关,同理心需求可能在个人希望得到同情和帮助的情况下较高,例如当个人经历不利事件、痛苦或控制力很小的时候。作者预期,在高同理心需求的情境中,对同理心支持的渴望会使个体更加关注他们对应方的情感能力,特别是在管理者与下属的关系中,管理者对个体有控制权,并能改善或恶化个体的状况。在情感上具有挑战性的时期,员工会寻求情感联系和富有同情心的管理。在这样的情境中,由于人工智能被认为缺乏情感体验,人类管理者在同理心和分享员工情感体验方面的更大能力,可能会使他们被认为在仁慈方面更高,并且比AI管理者更值得信任。然而,在低同理心需求的情境中,AI管理和人类管理的相对情感能力对于员工来说可能不那么重要。

- H1:AI管理者被感知为比人类管理者更缺乏仁慈。

- H2:AI管理者比人类管理者获得的信任更少,并且感知仁慈在其中起到中介作用。

- H3:情境对同理心的需求程度将调节AI管理通过感知仁慈对信任的间接关系,这种间接效应在情境需要更高同理心时比需要更低同理心时更强。

研究设计与结果

Study 1:Delivery Riders’ Trust of AI Management

样本:400名外卖骑手。

方法:在中国大陆进行现场调查,骑手在休息时填写问卷。

测量:其他变量的测量如常,对AI管理的测量是通过询问参与者他们是作为为平台工作的众包骑手(AI管理),还是作为有站长管理的外包骑手(AI + 人工管理)。

结果:假设1、2得到验证。

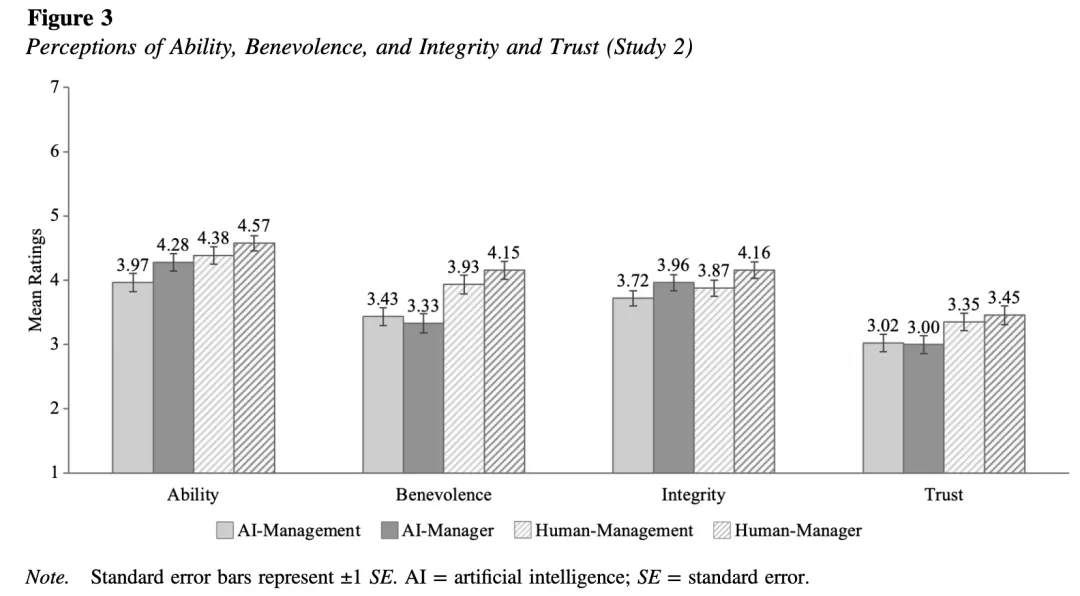

Study 2: Benevolence as Mediator

样本:400名美国全职员工。

设计:2(AI管理 vs 人类管理)× 2(管理者描述 vs 管理描述)

程序:参与者被要求想象他们作为食品配送平台 Company X 的配送司机,负责从餐厅取餐并及时将订单送达客户家中。

- 在 AI 条件中,告知参与者他们的管理者 Ari 是 Company X 的 AI 驱动系统。

- 在人类条件中,Ari 是区域经理。

接着,操纵参与者评价的是管理者 Ari 还是 Company X 的管理。

- 在管理者条件下,参与者评价 Ari。

- 在管理条件下,参与者评价 Company X。

结果:Study 2 通过实验方法验证了 Study 1 的发现,并进一步探讨了管理表述对信任的影响。研究发现,无论是 AI 还是人类管理者,当被表述为“管理者”而非“管理”时,参与者对其的信任度没有显著差异。

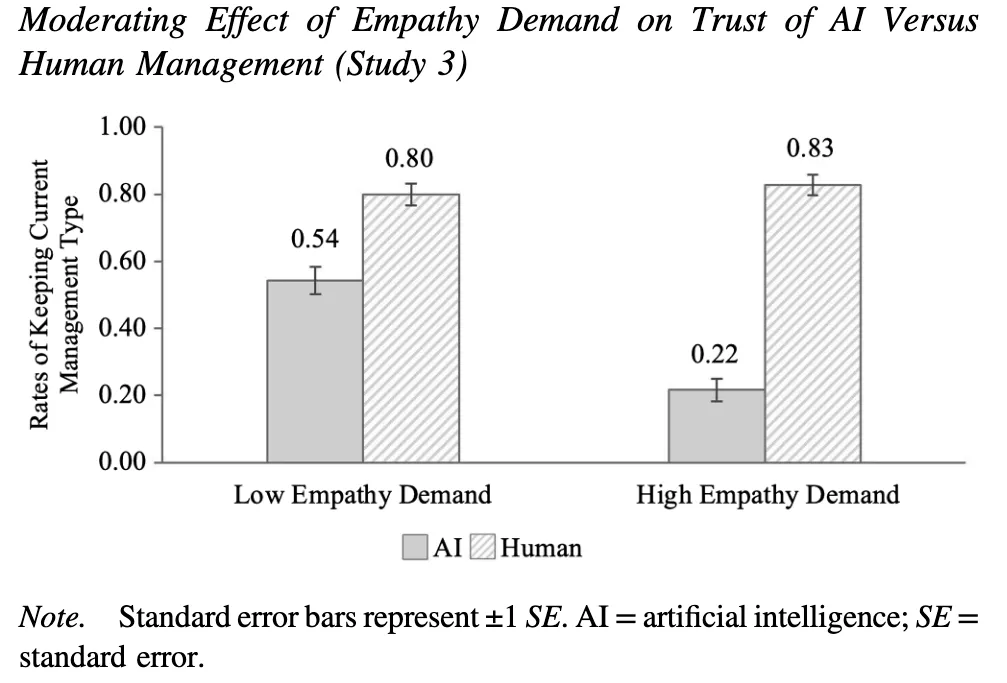

Study 3: Empathy Demand as a Moderator

样本:600名美国全职工作人员。

设计:2(AI管理 vs人类管理)× 2(高同理心需求 vs 低同理心需求)

程序: 参与者被要求想象他们是食品配送平台 Company X 的配送司机,负责从餐厅取餐并及时送达客户家中。 AI管理的操纵同上。 后续操纵了工作情境是否需要高度同理心。

- 在高同理心需求条件下,参与者想象他们在完成最后一单时遭遇车祸;

- 在低同理心需求条件下,参与者想象他们没有遇到任何问题。

参与者被告知他们的表现将由 AI 或人类管理者评估,并可以选择是否更换管理者类型。

测量:通过让参与者选择是否保留当前管理者或更换为另一类型的管理者来间接测量信任。

结果:在高同理心需求条件下,参与者更倾向于保留人类管理者而不是 AI 管理者。在低同理心需求条件下,参与者对于保留 AI 管理者或更换为人类管理者的态度没有显著差异。

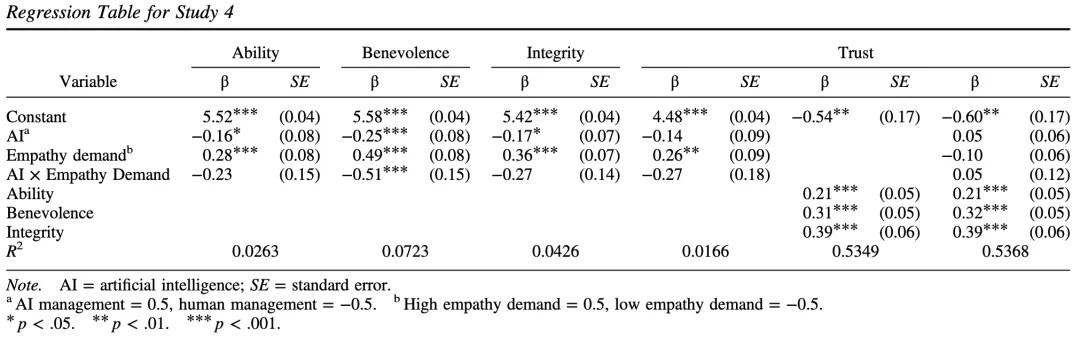

Study 4: Pilot Study and Main Study

作者先通过一个预实验构建了高情感需求的情景,随后才开展研究。

样本:800名至少有1年工作经验的美国员工。

设计:2(AI管理 vs人类管理)× 2(高同理心需求 vs 低同理心需求)

程序: 参与者被要求想象他们在 Company X 工作了 6 个月,并被随机分配。

- 在高同理心需求条件下,参与者被告知他们因母亲去世需要请假一周来处理葬礼和相关事宜;

- 在低同理心需求条件下,参与者被告知他们计划请假一周去度假。

接着,操纵了请假申请是由 AI 管理系统还是人类高级经理 Mike 审核和批准的。

结果:假设均得到支持。

这篇推送就到这里啦。又是一篇跟AI相关的文章,因为比较新,所以速速来分享一下。